A finales de 2013, Adam Mann esperaba un anuncio importante desde el pozo de una mina en Dakota del Sur. Como reportero de física y ciencias espaciales de Wired, Mann estaba siguiendo el experimento Large Underground Xenon(LUX) —en ese momento, el detector de partículas de materia oscura más sensible del mundo—, ubicado en el pozo de la mina. LUX había estado recolectando datos durante tres meses, con la esperanza de detectar señales de la principal candidata teórica sobre la posible forma de la materia oscura.

Finalmente, los resultados salieron: LUX había encontrado… nada. Ninguna señal que se viera como partículas de materia oscura. Fue un resultado nulo: los investigadores no encontraron evidencia que sostuviera sus expectativas teóricas. “Siempre es un poco decepcionante”, recuerda Mann, ahora escritor freelance. “Es difícil convencer a un editor de cubrir resultados nulos”. Y la mayoría de las veces, agrega, puede que no sea importante hacerlo.

Pero esta no era una de esas veces. En su cobertura, Mann explicó que los resultados —aunque no eran lo que los científicos esperaban— podrían refinar las expectativas teóricas acerca de cómo deberían verse estas partículas subatómicas. La ausencia de las señales predichas en un conjunto de datos excepcionalmente limpio aumentó la confianza en la sensibilidad del detector. Y el resultado desafió experimentos previos que habían afirmado detectar partículas de materia oscura de baja masa.

Aunque los resultados nulos pueden no sentirse como noticias, a veces revelan historias valiosas que muestran el progreso no lineal de la ciencia o que tienen implicancias importantes para los lectores, como si un tratamiento que se creía efectivo no lo es, o si un gobierno local está invirtiendo dinero en una intervención que no tiene efecto. Y aunque encontrar resultados nulos y evaluar su relevancia periodística puede implicar más trabajo que con los resultados positivos, el esfuerzo puede ayudar a los periodistas a ir más allá de las noticias tradicionales sobre estudios científicos, traer nuevas ideas y facetas a su reporteo, y aprender más sobre el funcionamiento interno de los campos que cubren. Finalmente, cubrir resultados nulos puede ayudar a los reporteros a contribuir a una visión más precisa de la ciencia y el mundo.

Pero primero, ¿qué es un resultado nulo?

Para entender los resultados nulos, el primer paso es entender lo que se conoce como “hipótesis nula”. Esto es la idea de que no hay una asociación estadísticamente significativa entre variables. Para sostener la hipótesis de que X tiene efecto sobre Y, por ejemplo, los investigadores necesitan evidencia fuerte de que la hipótesis nula —X no tiene efecto sobre Y— no es cierta. Para el experimento LUX, una versión simplificada de la hipótesis nula sería que todas las señales detectadas fueron consistentes con el fondo esperado de fuentes conocidas, sin interacciones de partículas de materia oscura.

Los resultados nulos pueden suceder por diferentes razones, que son importantes de entender para poder escribir sobre ellos de manera precisa.

O considera un ensayo clínico que evalúa si un nuevo medicamento alivia las migrañas. En ese caso, la hipótesis nula sería que el medicamento no tiene efecto. Entonces, los investigadores habrán encontrado un resultado nulo si, después del tratamiento, la diferencia en los puntajes de dolor de cabeza promedio de la gente en el grupo de placebo son estadísticamente indistinguibles de los de la gente en el grupo de tratamiento. En otras palabras, si hay una diferencia en la muestra, es demasiado pequeña para concluir que existe una diferencia real en la población.

Los resultados nulos pueden suceder por diferentes razones, que son importantes de entender para poder escribir sobre ellos de manera precisa. A veces, un resultado nulo puede indicar que la hipótesis nula es correcta. Otras veces, puede significar que simplemente no hay suficiente evidencia para descartar la hipótesis nula con confianza, más allá de si es realmente correcta. Este último caso muchas veces surge de limitaciones metodológicas. Al estudio le puede haber faltado suficiente poder estadístico —la probabilidad de detectar un efecto real si ese efecto existe—. Si el efecto es más débil de lo esperado o los datos están afectados por factores como la variabilidad aleatoria o los errores de medición, por ejemplo, puede ser necesario un mayor tamaño de muestra para detectar un efecto real.

De todas formas, ambos tipos de resultados nulos pueden ayudar a que la ciencia avance. No solo ayudan a refinar hipótesis y métodos, sino que también evitan que otros investigadores gasten tiempo y recursos en caminos que ya fueron explorados. “Los mejores experimentos son aquellos que, no importa cuál respuesta obtengas, te ayudan a avanzar hacia el próximo experimento”, dice la periodista freelance y bioestadística Viviane Callier.

Cómo encontrar resultados nulos

Aunque ocasionalmente un estudio con un resultado nulo llega a una revista científica de primer nivel, es más usual que estos estudios encuentren un lugar en revistas de nicho o de menos impacto. La periodista de ciencia freelance Laura Dattaro dice que su proceso para detectar historias para su boletín electrónico Null and Noteworthy, publicado hasta julio de 2025 por The Transmitter, incluía “rastrear entre muchas y muchas investigaciones”. También revisaba una Airtable compartida por toda la redacción, que usaban para llevar un registro de estudios científicos sobre neurociencias, y donde buscaba resultados nulos en aquellos que no se habían convertido en historias. Además, a menudo recurría a manuscritos preliminares, o preprints. Tenía alertas de Google Scholar para combinaciones de los términos “neurociencia”, “sin evidencia”, “nulo” y “replicación”.

Los trabajos sin publicar pueden ser otra fuente de resultados nulos potencialmente relevantes periodísticamente, si es que puedes encontrarlos.

Sin embargo, la mayoría de los resultados nulos no llegan a un artículo publicado o a un manuscrito. En una encuesta publicada por Springer Nature el 22 de julio, que involucró a más de 11.000 investigadores, el 98% reconoció el valor de compartir resultados nulos, y el 53% dijo que había obtenido ese tipo de resultados en algún momento. Aún así, solo el 30% los había enviado a revistas científicas. Entre las razones que citaron estaban “preocupaciones sobre el sesgo negativo que lleva al daño reputacional” y una “baja probabilidad de aceptación por parte de las revistas”.

Esto lleva a lo que se conoce como “file-drawer problem” en inglés, o el problema del archivero. “Alguien realiza un estudio, no funciona, y simplemente lo archiva”, dice Jesse Gubb, un gerente sénior de investigación en J-PAL, un centro de investigación que se centra en evaluaciones de impacto, y quien ha escrito sobre resultados nulos. Y hay muchos resultados nulos en el camino al éxito, agrega. “Entonces, cuando miramos las investigaciones publicadas en su conjunto, estamos obteniendo una imagen sesgada de lo que funciona. No estamos viendo lo que no funcionó”.

Los trabajos sin publicar pueden ser otra fuente de resultados nulos potencialmente relevantes periodísticamente, si es que puedes encontrarlos. Una manera de espiar en estos cajones, dice Mann, es escuchar las secciones de preguntas y respuestas de las conferencias, “donde otros [científicos] se levantan y responden, y puedes obtener un poco de idea de qué debate está sucediendo en el campo”. Cuando entrevista investigadores para un artículo, también les pregunta en qué otras cosas están trabajando. “Puede ser un comentario casual: “Ah, sí, estamos esperando X, Y y Z”, dice. “Con suerte, archivas eso en el fondo de tu mente o [en] una carpeta en algún lado con ideas para historias”. Luego, haz un seguimiento con los investigadores para ver cómo resultaron los estudios, y revisa regularmente los servidores de preprints como arXiv.

Los periodistas también pueden examinar estudios planificados o ensayos clínicos en marcha. Las bases de datos como el registro internacional de la Organización Mundial de la Salud y el sitio de ensayos clínicos de los Institutos Nacionales de Salud de Estados Unidos son tierra fértil para resultados nulos. Algunos estudios, incluyendo muchos ensayos clínicos, producen documentos llamados “prerregistros”. Estos planes del estudio especifican no sólo las preguntas originales de los investigadores y sus hipótesis, sino también sus planes de preanálisis, donde definen cómo se vería un efecto y el tamaño de muestra necesario para detectarlo a los niveles de poder estadístico y confianza deseados. Los prerregistros pueden encontrarse en algunas plataformas de ciencia abierta, como la OSF, y bases de datos específicas de distintos campos. “Escribirles correos a los autores sobre sus prerregistros y hacerles saber que estás interesado en sus hallazgos cuando los tengan pueden ser útil”, dice Dattaro.

Evaluar y contextualizar resultados nulos

Una vez que has encontrado un resultado nulo, ¿cómo decides si vale la pena escribir sobre ese no-hallazgo, especialmente cuando estás lidiando con preprints o trabajo sin publicar, que todavía no pasó por la revisión de pares? Esta parte del proceso de reporteo se parecerá mucho a cubrir resultados positivos. Puedes evaluar si el diseño del estudio, su implementación y su metodología son robustas al hablar con investigadores en el mismo campo que no hayan estado involucrados en el estudio.

Para determinar con cuál de los dos tipos de resultados nulos estamos tratando —uno que indica con seguridad que no hay ningún efecto o asociación real, o uno en el que simplemente no había suficientes datos para llegar a una conclusión— también puede ser necesario entrar un poco en el terreno metodológico: ¿La muestra era lo suficientemente grande para detectar un efecto si ese efecto existiera? ¿El estudio tenía suficiente poder estadístico? Dado que no hay reglas generales para qué tamaño necesita tener una muestra (varía de campo a campo y de estudio a estudio), estas son todas buenas preguntas para hacer a los expertos que consultamos. Los periodistas pueden encontrar ayuda analizando estadísticas a través de este programa de Sense about Science USA y la Asociación Estadounidense de Estadística.

Una vez que has encontrado un resultado nulo sobre el que vale la pena escribir, necesitas lograr el balance adecuado entre mostrar por qué el no-hallazgo es relevante, pero sin sobrevenderlo.

Para evaluar qué tan importantes son los resultados nulos, Mann recomienda hacerles preguntas directas a los investigadores, como “¿por qué nos debería importar esto?”. Callier también sugiere preguntar acerca de las implicancias prácticas del resultado para áreas como las políticas públicas y la salud pública. Por ejemplo, un estudio sobre el efecto de los anticonceptivos gratuitos en Burkina Faso encontró que, en contra de las expectativas, reducir las barreras económicas para acceder a anticonceptivos no tiene un efecto detectable en la tasa de fertilidad. Los investigadores instan a que los resultados no se interpreten como un argumento a favor de quitarle financiamiento a la planificación familiar sino como un llamado a producir más investigación para entender qué está impulsando la fertilidad alta —y que podría de hecho conducir a políticas que se adapten mejor a ese contexto cultural específico—. Las implicancias complejas de las diferentes interpretaciones podrían dar lugar a oportunidades de reporteo en profundidad e historias importantes sobre salud pública.

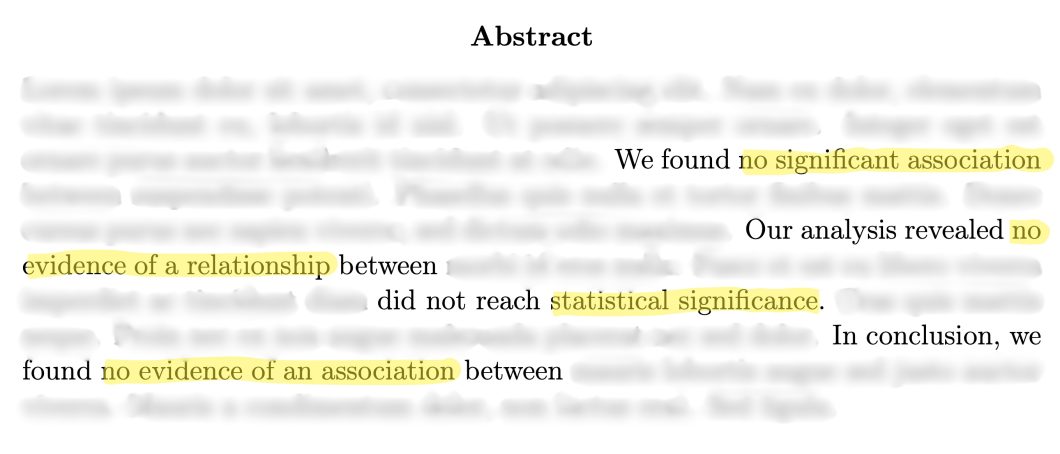

La historia más amplia que condujo a los investigadores a un resultado nulo también puede ayudar a los periodistas a evaluar si es periodísticamente relevante. “Los resultados nulos se pueden poner realmente interesantes cuando desafían algo que la gente pensaba que sabía, o cuando es un resultado realmente diferente de lo esperado con base en evidencia pasada”, dice Dattaro. Los abstracts, o resúmenes, y las introducciones de los artículos científicos muchas veces ofrecen pistas hacia esas historias. “A veces, tienen estos relatos largos, como, ‘bueno, tal y tal en 1997 encontraron esto, después otra persona [hizo tal otra cosa]’”, dice. Esto muestra que “este resultado es en realidad lo último en una larga línea de investigación científica, y eso lo hace verdaderamente interesante”.

Desde la perspectiva de un editor, tener estos elementos desplegados en un pitch aumenta las chances de que sea aceptado. Clarice Cudischevitch, editora de la columna Ciência Fundamental (Ciencia Fundamental), publicado por el periódico brasileño Folha de S.Paulo, dice que cuando está considerando una propuesta sobre un resultado nulo se fija en “[si] la historia es una buena oportunidad para explorar el proceso científico, … mostrar el detrás de escenas”, dice. “También miraría si la historia trae lo inesperado y si tiene alguna novedad”.

Encuentra el “porqué” para construir tu historia

Una vez que has encontrado un resultado nulo sobre el que vale la pena escribir, necesitas lograr el balance adecuado entre mostrar por qué el no-hallazgo es relevante, pero sin sobrevenderlo. Un arco narrativo fuerte puede ilustrar cómo los resultados ayudan a avanzar a la ciencia o impactan en la vida de las personas, apoyado por una elección de palabras que clarifique qué es lo que se encontró y qué no.

Prestar atención a las motivaciones iniciales de los científicos —¿por qué estaban buscando una asociación entre X e Y en primer lugar?— puede ayudar a identificar el núcleo narrativo de una historia. Dattaro escribió en The Transmittersobre una oleada de estudios que examinaban si la anestesia epidural durante el parto estaba asociada a un aumento de la probabilidad de tener un hijo con autismo (spoiler: no, no existe asociación alguna). La periodista se empezó a preguntar por qué tantos investigadores de repente estaban explorando esa pregunta, para solo encontrar resultados nulos una y otra vez. La chispa detrás de esta reacción en cadena resultó ser un solo estudio que había reportado un resultado positivo —pero espurio— sugiriendo que ese vínculo existía.

Muchas veces, escribir sobre resultados nulos implica resaltar cómo desafiaron aquello que se creía cierto.

La historia de Dattaro es sobre resultados nulos, pero también sobre mucho más: autismo y desinformación, el carácter autocorrectivo de la ciencia, y el riesgo que viene con la sobrerrepresentación de los resultados positivos tanto en revistas científicas como en los medios de comunicación. El sesgo de publicación que favorece a los resultados positivos puede llevar a que afirmaciones falsas sean “canonizadas” y aceptadas como hechos, según encontró un estudio, y publicar más resultados nulos puede ayudar a reducir este efecto.

Muchas veces, escribir sobre resultados nulos implica resaltar cómo desafiaron aquello que se creía cierto. Pero los estudios sobre autismo y epidurales acerca de los cuales escribió Dattaro pertenecen a una categoría en la que caen muchos resultados nulos: la categoría de “sí, ya sabía esto, nada nuevo por aquí”. De todas maneras, al mirar la historia más amplia, logró mostrar de manera convincente cómo se construye, se desafía y se refuerza el consenso científico a través de acumular más evidencia.

Como editora, Cudischevitch trabaja con sus escritores para asegurarse de que sus artículos muestren por qué estos resultados aparentemente aburridos son pasos importantes en la producción de conocimiento. “La confianza en la ciencia no debería venir de mostrar solo las cosas revolucionarias que la ciencia hace. … [Lo revolucionario] es muy inusual, y que suceda lleva tiempo”, dice. “Los resultados nulos o negativos son una oportunidad para mostrar el progreso científico”.

Para reflejar ese aspecto incremental de la ciencia, los reporteros deben describir los resultados con precisión y evitar la tentación de sobrevender los resultados nulos. Callier recomienda frases como “ninguna diferencia fue detectada” frente a “no hubo efecto”. También es importante que la elección de palabras refleje claramente la distinción entre un resultado nulo que realmente no muestra un efecto y uno basado en limitaciones metodológicas. En el segundo caso, frases como “la evidencia no fue concluyente” pueden funcionar mejor, por ejemplo.

Incluso si ese tipo de lenguaje prudente pero preciso no suena emocionante, los periodistas pueden agregar entusiasmo a través de otras facetas de la historia. Es importante recordar que una historia sobre un resultado nulo va a tratar sobre algo más que estadística. Va a tratar sobre el conocimiento y cómo guía nuestras decisiones. En su historia de 2013 sobre el experimento LUX, Mann recuerda lo importante que fue enfocarse en lo que llama “la tensión de la historia”. Esto incluye los desacuerdos dentro del campo, los experimentos previos que habían mostrado resultados positivos, y las ideas ampliamente aceptadas sobre la materia oscura que aquel resultado nulo desafiaban.

“El proceso de la ciencia no consiste simplemente en: ‘Experimento revela la verdad’. Es [más] como: ‘Un experimento sucede y luego todos lo miran desde sus ángulos particulares y discuten sobre cuáles son la interpretación y significado exactos’”, dice. “Nuestro trabajo como periodistas es darle al lector un entendimiento más claro sobre el hecho de que esto es en realidad lo que pasa en la ciencia”.

Lucila Pinto es periodista freelance de ciencia y tecnología. Su trabajo ha aparecido en Science, Rest of World, y La Nación, entre otros. Es becaria del Pulitzer Center y graduada del máster en periodismo científico de la Universidad de Columbia. Actualmente, es becaria de The Open Notebook, con apoyo del Burroughs Wellcome Fund. Puedes seguirla en X como @luchipaint y en LinkedIn.